二年ぶりぐらいにメジャーバージョンが更新されました。[公式リリース] [ダウンロード]

今回の目玉機能としてHTTP/2対応とDirectorのConsistent Hash対応があります。

なにはともあれ、とりあえずHTTP/2を使うセットアップをしてみましょう。

Hitch1.4.0+Varnish5でHTTP/2を使う

Varnishはよく知られてるようにHTTPSに対応していません。

HTTP/2に対応したこのバージョンにおいても、やはり本体では対応をしていません。

そのため通常のブラウザからVarnishに対してHTTP/2にアクセスするにはTLSを解かなくては行けません。

今回はVarnishSoftwareが提供しているHitchを利用します。

なお、HTTP/2を利用するには1.4.0以降のバージョンが必要です。

また、一部ディストリビューションではパッケージが提供されていますが、私が利用しているUbuntu 16.04向けのパッケージはなかったのでソースからbuildしていきます。

Hitchのインストール

公式手順を参考に行います

sudo apt-get install libev-dev libssl-dev automake python-docutils flex bison pkg-config

git clone https://github.com/varnish/hitch.git

cd hitch

./bootstrap

./configure --prefix=/opt/hitch/

make

sudo make install

これだけです。(prefixはお好きなところにでも)

なお、HTTP/2を使うにはNPNもしくはALPNのサポートが必要です。

NPNはOpenSSL1.0.1、ALPNの場合は1.0.2が必要ですが、既にChromeでは今年の6月ごろにNPNでのHTTP/2サポートは打ち切られALPNのみでのサポートとなりました。

そのため実質HTTP/2を利用するにはALPNをサポートしている必要があります。

とりあえず確認する程度であれば、FireFox49はNPNでも接続できるので1.0.1でも問題はないです。

Hitchの設定

HTTPS:443 HTTP:80

↓ ↓

Hitch:443--(localhost:81)-->Varnish:80

↓

Origin

今回はこんな感じで構成します。

まずはHitchの設定です。

#/etc/hitch/hitch.conf

frontend = "[*]:443"

ciphers = "ECDHE+RSAGCM:ECDH+AESGCM:DH+AESGCM:ECDH+AES256:DH+AES256:ECDH+AES128:EECDH+HIGH:EDH+HIGH:HIGH:+3DES:!RC4:!MD5:!aNULL:!eNULL:!LOW:!EXP:!PSK:!SRP:!DSS:!KRB5:!DH"

backend = "[127.0.0.1]:81"

write-proxy-v2 = on

workers = 2

backlog = 1024

keepalive = 3600

syslog = on

user = "nobody"

daemon = on

alpn-protos = "h2,http/1.1"

pem-file = "/etc/hitch/******.pem"

ciphersとかは割と適当ですがきちんと設定したい人はこちらで考えると良いかと思います。

なお、hitchのpem-fileは

秘密鍵 + 証明書 + 中間CA証明書 + dhparam

です。

Let’s Encryptでやる場合は

privkey.pem + fullchain.pem + dhparam

になります。

また、どうやって複数のvhostsに対応するのかというとpem-fileを列挙します。

ちなみにデフォルトのものは最後に定義されたものになります。

Hitchの起動

/opt/hitch/sbin/hitch --config=/etc/hitch/hitch.conf

次はVarnishの設定です。

Varnishの設定

まずはListenの指定をしましょう。

ポート80で通常のHTTPを受付して81でPROXYプロトコルで受付します。

そのための設定はこのような感じです。

-a :80 \

-a 127.0.0.1:81,PROXY \

また、HTTP/2はデフォルトでは有効にされていません。

そのためfeatureでhttp2を指定する必要があります。

varnishadmから設定する場合は

root@proxy02:~# varnishadm param.set feature +http2

root@proxy02:~# varnishadm param.show feature

feature

Value is: +esi_disable_xml_check,+http2

Default is: none

Enable/Disable various minor features.

none Disable all features.

Use +/- prefix to enable/disable individual feature:

short_panic Short panic message.

wait_silo Wait for persistent silo.

no_coredump No coredumps.

esi_ignore_https Treat HTTPS as HTTP in

ESI:includes

esi_disable_xml_check Don't check of body looks like

XML

esi_ignore_other_elements Ignore non-esi XML-elements

esi_remove_bom Remove UTF-8 BOM

https_scheme Also split https URIs

http2 Support HTTP/2 protocol

です。

起動パラメータで指定する場合は

-p feature=+http2 \

を追加すれば良いです。

これで動作します。

なお、後述しますが絶対本番環境では行わないでください。

それでは、HTTP/2での動作のさせかたを紹介したところで、いつも通り新機能などの紹介を行います。

全体的な話

過去のメジャーバージョンアップを振り返ってみると

2.1->3.0

3.0->4.0

- リクエスト・フェッチ・レスポンスといった一連の動作をClient/Backendスレッドに分割

- VCLにバージョン番号付与とスレッド分割に対応するための変更

4.0->4.1(マイナーバージョンアップですが)

- PROXYプロトコルのサポート

- 内部処理にフックできるようなしくみの追加

4.1->5.0

- HTTP/2の実験的サポート

- shard director(consistent-hash)対応

- バックエンドフェッチがPROXYプロトコルサポート

- 別VCLを動的リンクして使うlabel機能のサポート

こうしてみると4.0の頃からHTTP/2の準備を着実にすすめていたのがわかるかと思います。

また、嬉しいことに5.0では3.0->4.0のときのような破壊的なVCLの変更はありません。

もちろん幾つかのVCLの変更はあります。

しかし大抵の場合は変更せずとも動き、もしくは少しのreplaceで済んでしまいます。

また、statsの項目も削られたものはあるものの出力フォーマットは変わっておらず、

LOGについてもHTTP/2関連の追加はあるものの大きな変更はなく、

大抵のVMODもリビルドすれば動き、累積バグは修正されています。

そのため、4.1で動いていた監視や周辺ツールはほぼ変更なしで動き既存の資産を使いやすいと思います。

10/03時点で知り合いのサイトの本番に投入して、20日程度経過していますが大きな問題もなく動作しています。

当然メジャーバージョンアップのため慎重な検証は必要ですが、3.0->4.0のときのような苦しみはなく

HTTP/2を使わないのであれば、どちらかと言うと4.0->4.1のときのような変更と思ってもらえればよいかと思います。

新機能

HTTP/2のサポート(experimental)

先程も紹介しましたがHTTP/2の極めて実験的(Very Experimental)なサポートを行っています。

有効にする場合は起動パラメータ、もしくはvarnishadmでfeatureパラメータを+http2に指定します。

なお、現時点で私が確認しているバグだと回避不能でリクエストで容易にクラッシュを起こすものが1件、回避可能なものが1件、仕様なのか判断できないが実装漏れっぽいのを1件見つけてます。(また今度泣きながら英語書きます)

そのため決して本番に投入することはおすすめしません。

しかし実際に触ってみていろいろバグを見つけて報告するとよいかと思いますので触ってみてほしいところです。

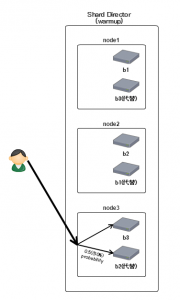

vmod-directorでsharedをサポート

consistent-hashのサポートです。

元々はUPLEXが提供していたvslpを公式に持ってきた形になります。

consistent-hashについてはぐぐるといろいろ出てくるとおもうので詳しくは割愛します(参考)

今まではbackend数に変動があった場合には全体で再計算が走るのでキャッシュヒット率が全体で落ちる問題がありましたがこれを使うことで解決することが出来ます。

特に複数台のクラスタで複数段のキャッシュを組んでる環境ではかなり効いてくると思います。

VOID shard.set_rampup(DURATION duration=0)

0秒以上を指定した場合、バックエンドがhealthyになった場合にいきなり100%のトラフィックを流すのではなく、指定秒数(duration)の間に徐々にトラフィックを流していくようになります。(slow start)

BOOL shard.add_backend(BACKEND backend, STRING ident=0, DURATION rampup=973279260)

バックエンドを追加します。

identはノードの識別子で、デフォルトではバックエンドの名前を使うようになっています。

通常は使うことはないと思いますが、weight的な指定をしたいときなどに使うと良いかもしれないです。

rampupはサーバ個別に指定する場合に指定します。(973279260はmagic valueでset_rampupで指定された値を使うようになります)

BOOL shard.remove_backend(BACKEND backend=0, STRING ident=0)

バックエンドを削除します。

backendを指定した場合は一致するすべてが削除されます。

BOOL shard.clear(PRIV_TASK)

全てのバックエンドを削除します。

VOID shard.set_warmup(REAL probability=0.0)

指定の確率で次の代替バックエンドにリクエストがいくようになります。(0.5=50%)

要はそのバックエンドが死んでキャッシュが落ちたとしても、

代替バックエンドがキャッシュをある程度持っている状態なのでダウン時の影響をより減らすことができるようになります

(ただし当然ながらキャッシュの二重持ちが起きるので空間効率は悪くなります)

なお、rampup期間中のバックエンドはwarmupの対象外になります。

BOOL shard.reconfigure(INT replicas=67, ENUM {CRC32,SHA256,RS} alg=”SHA256″)

consistent-hashで使うハッシュリングを作ります。

replicasは1つのバックエンドが仮想的に何個のバックエンドになるかです。(consistent-hashの仮想ノード)

algはどのハッシュ関数を使ってハッシュリングに配置していくかです。

なお、shardディレクターを使う場合は必ず一度は呼び出す必要があります。

イメージ的にはcommitと思ってもらえれば良いかなと思います。

BACKEND shard.backend(ENUM {HASH,URL,KEY,BLOB} by=”HASH”, INT key=0, BLOB key_blob=0, INT alt=0, REAL warmup=-1, BOOL rampup=1, ENUM {CHOSEN,IGNORE,ALL} healthy=”CHOSEN”)

バックエンドを選択します。

by=HASH(デフォルト)

vcl_hashで生成したhash値を使用して振り分けサーバを決めます。

by=URL

req.url/bereq.urlを使用します。

by=KEY

keyで指定したINT数値を使って振り分けします。

例えばcookieをもとに振り分けしたい場合は

shard.backend(by=KEY,key=shard.key(bereq.http.cookie))

といった感じです。

by=BLOB

key_blob指定したblobを使って振り分けします。

通常は使うことはないと思います。

また、blob全体を使うのではなく先頭4バイトを使用します。

key

by=keyを指定した場合に指定する数値です

key_blob

by=blobを指定した場合に使用するblobです

alt

指定した場合はn番目の代替バックエンドを選択します。

どのようなときに使うかというと何かしらのエラーが起きて別のバックエンドを選択したい場合(restart/retries時)に使用します。

alt=req.restart or bereq.retriesと指定しているとリスタート/リトライのたびに別のバックエンドを選択することが出来ます。

なお、rampup/warmupはaltが0のときのみ有効で、1以上のときはaltが優先されます。

warmup

代替サーバが選択される確率を指定します。(-1,0~1)

-1の場合はset_warmupで指定した値を使用します。

rampup

rampup機能を使うかどうかです。

healthy=CHOSEN(デフォルト)

healthyなバックエンドを選択します。

altが0以上の場合はバックエンドのhealthyを無視してn番目の代替バックエンドを選択します。

ドキュメントにはthen return the next healthy backend.とあるのですが、コードと実際の動作を見る限りだとalt指定時の代替バックエンド選択ではhealthyかの評価をしていません。

healthy=IGNORE

helathyを無視します。

altを指定した場合はhealthyを無視した状態で代替バックエンドを選択します。

またrampup/warmupは機能しません。

healthy=ALL

基本的にはCHOSENと同じですが、altが0以上のときに代替バックエンドを選択する際にもヘルスチェックをします。

ちょっとややこしいのでまとめてみました

| healthy |

alt==0 |

alt>0 |

| CHOSEN |

ヘルスチェックを行う |

ヘルスチェックを行わない |

| IGNORE |

ヘルスチェックを行わない |

ヘルスチェックを行わない |

| ALL |

ヘルスチェックを行う |

ヘルスチェックを行う |

INT shard.key(STRING string, ENUM {CRC32,SHA256,RS} alg=”SHA256″)

指定した文字列を指定したハッシュアルゴリズムを通したときのINT値を得ます。

例えばSHA256は256bitなんですが、32bit分だけ返します。

この関数はshard.backendをby=KEY指定で使う場合に使用します。

で、実際のところどうやって使うかというとこんな感じです。

sub vcl_init {

new ws_cache = directors.shard();

ws_cache.set_rampup(10s);

ws_cache.add_backend(ws01);

ws_cache.add_backend(ws02);

ws_cache.add_backend(ws03);

ws_cache.add_backend(ws04);

ws_cache.reconfigure();

}

sub vcl_recv {

//x-varnish-hashにはユーザIDとかそんなのが入ってる

...

set req.backend_hint = ws_cache.backend(by=KEY, key=ws_cache.key(req.url + ":" + req.http.host + ":" + req.http.x-varnish-hash));

}

INT,BACKEND型がBOOLで評価できるようになりました

こういうことができるようなります。

sub vcl_recv {

if(1){

set resp.http.foo = "1";

}

if(req.backend_hint){

set resp.http.bar = "1";

}

}

INT型で0はfalseになります。

また、BACKEND型では割り当てられていない場合はfalseになります。

別VCLを動的リンクして使うlabel機能のサポート

いままで異なるVCLを読み込む方法としてはincludeがありました。

これは単純にincludeを記載した場所に指定したVCLを展開するものでした。

そして今回追加されたlabelは別のコンパイルされたVCLを動的リンクします。

とりあえず使い方を紹介します

まずラベルを持つVCLをloadします

varnishadm vcl.load a_example_net /etc/varnish/a_examplet_net.vcl

varnishadm vcl.load b_example_net /etc/varnish/b_examplet_net.vcl

varnishadm vcl.load c_example_net /etc/varnish/c_examplet_net.vcl

varnishadm vcl.label vcl_a_example_net a_example_net

varnishadm vcl.label vcl_b_example_net b_example_net

varnishadm vcl.label vcl_c_example_net c_example_net

default.vcl

vcl 4.0;

//最低限1つはバックエンドがないと動かないのでダミー

backend default { .host = "127.0.0.1"; }

sub vcl_recv {

if(req.http.host ~ "a\.example\.net$"){

return(vcl(vcl_a_example_net));

}

if(req.http.host ~ "b\.example\.net$"){

return(vcl(vcl_b_example_net));

}

if(req.http.host ~ "c\.example\.net$"){

return(vcl(vcl_c_example_net));

}

return (synth(403));

}

a.example.netの場合はvcl_a_example_netというラベルを持つVCL(/etc/varnish/a_examplet_net.vcl)を使うようになります。

これは何に使えるかというとCDNのMWとしてVarnishを使っていたりして外部の人にVCLの記述を解放したいけど

VCLがそれぞれ干渉しないようにしたい場合に使えます。

vcl_a_example_netの中からb.examplet.netに関する処理を書いてもそもそもそういうリクエストが割り振られないからです。

また、今回はreq.http.hostで分けましたが、もちろん他のキーで振り分けを行うことが出来ます。

なお、設定を更新する場合は再度vcl.loadしてvcl.labelを叩く感じです

varnishadm vcl.load a_example_net_1 /etc/varnish/a_examplet_net.vcl

varnishadm vcl.label vcl_a_example_net a_example_net_1

ちなみにvcl.listを見てみるとこんな感じになります

# varnishadm vcl.list

active auto/warm 0 boot

available auto/warm 0 a_example_net

available label/warm 0 vcl_a_example_net -> a_example_net_1

available auto/warm 6 a_example_net_1 (1 label)

vcl_a_example_netがa_example_net_1になっているのがわかると思います。

また、reloadを行った場合はラベルの先のVCLについてはreloadされませんので注意が必要です。

バックエンドフェッチがPROXYプロトコルサポート

バックエンドの定義に.proxy_header=[プロトコルバージョン];を指定することでproxyプロトコルが使えるようになりました。

backend ws01 {.host = "192.168.1.1";.proxy_header = 1;}//PROXYプロトコルv1

backend ws02 {.host = "192.168.1.2";.proxy_header = 2;}//PROXYプロトコルv2

varnishtestの強化・変更

HTTP/2のテストやproxyプロトコルのサポートが行われました。

また、resp.msgはresp.reasonへ

semaはbarrierに名前が変更されました。

std.integerがREAL型の数値をパースできるようになりました

1.2といったものはもちろん1E+2みたいな表記もパースできるようになりました。

もちろんINT型になるように小数点以下は削除されます。

std.logがvcl_initで動くようになりました

varnishhistにy軸の目盛りが付きました

varnishstatの-fオプションがglob(7)の形式が使えるようになりました

POSTをキャッシュできるようになりました

正確にはVCLを正しく書けばPOSTもキャッシュできるようになったということです。(もちろんデフォルトではされないです)

内部的な変更としてbodyを常にバックエンドに送るように変更されており、これによりGETとbodyを使うPOSTなどと扱いが変わらなくなったためです。

とはいえGETはbodyがいらないのでbuiltin.vclでは削除するようになっています。

sub vcl_backend_fetch {

if (bereq.method == "GET") {

unset bereq.body;

}

return (fetch);

}

もし、自身のVCLがbuiltin.vclを通らない(return)している場合はunset bereq.bodyを追加する必要があるでしょう。

また、POSTのキャッシュができるようになったとはいえbuiltin.vclではやはりpass動作になっています。

試していませんがここをhashにすればキャッシュできると思いますが、オブジェクトのハッシュを作る際にbodyを評価していないため

ここらへんはbodyに対してアクセスできるvmodを使って中身を精査してハッシュを作る必要があります。

仕様変更

statsからn_waitinglistがなくなりました

VCL名に指定可能な文字が制限されました

わざわざvcl名を使っている人はそんなにいないと思うんですが

[A-Za-z][A-Za-z0-9_-]*にマッチする名前じゃないとだめになりました。

すべてのVCLオブジェクトは使う前に定義しないといけなくなりました

backendとかaclとかそういうのですね、むしろ今まで意識してなかった(いつも先頭に持ってきてた)ので

え、いけたの?ぐらいです。

pass(uncacheable)されたリクエストではcache-control/ExpiresのTTLはパースされなくなりました

今まではpassした場合でもTTLのパースはしていたのですがされなくなったので、対応するログも出力されなくなりました。

-T/-Sを無効化する場合は明示的にnoneを指定する必要があります

パラメータの変更

追加:ban_lurker_holdoff

効率的でないbanの指定などでban.listが肥大化した場合、ban_lurkerスレッドとの潜在的な競合によりlookup性能が悪化するケースがありました。これを防ぐためにsleepを入れるようになってその値です。

デフォルトは0.1sとban_lurker_sleepと同じです。

追加:session_max

session_maxは削除されました。

もともと4.0のリリースで効果がなくなったものです。

なお、将来的に復活する可能性はあるとのことです。

名前の変更:vcl_dir->vcl_path / vmod_dir->vmod_path

まだどちらも使えますがおそらく将来的に_dirのほうはなくなります。

また、:で分割して複数のpathを指定できるようになりました。

vcl_pathのデフォルトは/etc/varnish:/usr/share/varnish/vclとなっていますが

これはincludeなどでVCLを読もうとした際にまず/etc/varnishを探索し、

存在しない場合は/usr/share/varnish/vclも探すといった動きになります。

また、/usr/share/varnish/vclにはデバイスを判定するためのdevicedetect.vclが入っていています。

builtin.vclの変更点

GET時にbereq.bodyのunset

これは先程「POSTをキャッシュできるようにしました」で説明したとおりです。

hit-for-passの取扱について

今まではreturn(pass)したりそもそもキャッシュできないオブジェクトはhit-for-pass(HFP)としてマークされて

2分間は常にpass扱いとされていましたが、HFPとしてマークしないようにしました。

以下が4.1と5.0のdiffです。

sub vcl_backend_response {

- if (beresp.ttl <= 0s ||

+ if (bereq.uncacheable) {

+ return (deliver);

+ } else if (beresp.ttl <= 0s ||

beresp.http.Set-Cookie ||

beresp.http.Surrogate-control ~ "no-store" ||

(!beresp.http.Surrogate-Control &&

beresp.http.Cache-Control ~ "no-cache|no-store|private") ||

beresp.http.Vary == "*") {

- /*

- * Mark as "Hit-For-Pass" for the next 2 minutes

- */

+ # Mark as "Hit-For-Pass" for the next 2 minutes

set beresp.ttl = 120s;

set beresp.uncacheable = true;

}

VCLの変更点

backendsの定義に.proxy_headerが追加されました

新機能で触れたものです

vcl_recv:returnにvcl(label)が追加されました

新機能で触れたものです

vcl_recv:rollbackが削除されました

vcl_hit:return(fetch)が削除されました

元々4.1の時点でfetch->missに変更するようにアナウンスが出てたものですが、このタイミングで削除さらえました。

vcl_backend_*:remote.ip, client.ip, local.ip, server.ipにアクセスできるようになりました

vcl_backend_fetch:bereq.bodyが追加されました

新機能で触れたものです

vcl_backend_error:synthetic()がberesp.bodyに変更されました

こんな感じの表記になります

set beresp.body = {"<!DOCTYPE html>

<html>

<head>

<title>"} + beresp.status + " " + beresp.reason + {"</title>

</head>

<body>

<h1>Error "} + beresp.status + " " + beresp.reason + {"</h1>

<p>"} + beresp.reason + {"</p>

<h3>Guru Meditation:</h3>

<p>XID: "} + bereq.xid + {"</p>

<hr>

<p>Varnish cache server</p>

</body>

</html>

"};

vcl_synth:synthetic()がresp.bodyに変更されました

vcl_deliver: obj.ttl, obj.age, obj.grace, obj.keepにアクセスできるようになりました(read)

正規表現でmatchした時の結果をBOOLとしてそのままセットできるようになりました

set req.http.foo = req.http.bar ~ "bar";

このような表記ができるようになりました。

アップデート時の注意

パッケージの構成が変更された

元々は

- Varnish本体

- libs

- libs-dev

- docs

の4種類でパッケージが別れていたのですが

の2種類に変更されました。

そのためインストールするときに失敗する場合は一度既存パッケージをアンインストールしてみてください。

VMODのABIが変更されたのでリビルドが必要

VMODのABIが変更されたので使用しているVMODについてはリビルドが必要です。

環境によってはreloadに失敗するかも

これは私が引っ掛かった問題+私のsystemd力が低いのでパッと解決策が思いつかなかった問題なのですが

VCL名が仕様変更(先頭文字はアルファベットである必要がある)されたけど、reloadスクリプトがそれに追随していないように見えます。

Xenial(systemd)でリロードしようとするとこの部分のLOGNAMEが入らないため先頭がuuidになります。

uuidは数字を含むためreload時にVCL名の仕様変更に引っかかってしまう感じです。

とりあえず先頭にreload_とかつけとけば回避はできるのでもし引っかかった場合は

- vcl_label="${LOGNAME}${LOGNAME:+_}${uuid}"

+ vcl_label="reload_${LOGNAME}${LOGNAME:+_}${uuid}"

こんな感じで修正すると良いかなと思います。

また、私がRHEL/CentOSの環境を持っていないので試していませんが、おそらくRHELでも同様の問題がおきます。(:は使えない)

その他変更

累積バグが直ってたり、細かい改善があったりします。