5.0.0の後継の5.1.1がリリースされました。 [changelog] [リリース文] [changes] [Upgrading]

また、今回からパッケージがpackagecloudで提供されるようになりました。(packagecloud)

5.1.0はどうなったの?という話ですが、ちょっと問題となるバグがあったため翌日にすぐ5.1.1を出した感じです。

今回のリリースでは4.1.4/4.1.5で変更された内容と細かい機能修正(VCL変更含む)があります。(それについては割愛してます)

VCLの変更はあるものの修正しないと動かないような変更はないのでよほどのことがない限りそのまま動作するはずです。

なお、VMODについては動かなくなるものもあるので事前に使用しているものが動くかを確認したほうが良いでしょう。

また、累積バグも修正されているのですが、よほど修正されているバグで困ってない限りは本番への適用は一旦4月中旬までは様子見たほうが良いかと思います。(何もなかったらすいません)

機能強化

varnishdのパラメータ追加(-I [cli file])

workerが起動する前に指定されたcli file読み込まれます。

このファイルはvarnishのcliコマンド(vcl.loadやvcl.useなど)が列挙されています。

これがなんの役に立つのかというと、5.0.0で追加されたvclのラベル機能を使っている人には非常に便利な機能です。

以前紹介したとおりlabel機能を使うには先にvcl.loadを利用してラベルを定義する必要がありました。

しかしvarnishdでvclを読み込む-fオプションではラベルを指定できなかったため、有効に使うには別にスクリプトを作るなど若干めんどくさかった面も否定できませんでした。

しかしこのオプションを使うことでworkerが起動する前にラベル付きでvclを読み込むことができるので非常に楽になります。

vcl.load panic /etc/varnish_panic.vcl vcl.load siteA0 /etc/varnish_siteA.vcl vcl.load siteB0 /etc/varnish_siteB.vcl vcl.load siteC0 /etc/varnish_siteC.vcl vcl.label siteA siteA0 vcl.label siteB siteB0 vcl.label siteC siteC0 vcl.load main /etc/varnish_main.vcl vcl.use main

このようなcliファイルを作っておいて

sub vcl_recv {

if (req.http.host ~ "asite.example.com$") {

return(vcl(siteA));

}

if (req.http.host ~ "bsite.example.com$") {

return(vcl(siteB));

}

if (req.http.host ~ "csite.example.com$") {

return(vcl(siteC));

}

// Main site processing ...

}

このようなVCLを使うことでラベル機能を使うことが出来ます。

なお、コマンドの先頭に「-」をつけることでそのコマンドが失敗しても処理を続行することができます

起動に失敗する vcl.load nf /etc/varnish/notfound.vcl 起動に失敗しない - vcl.load nf /etc/varnish/notfound.vcl

varnishdのパラメータ追加(-x (parameter|vsl|cli|builtin))

これは何かしらの動作がというわけではなくて以下の情報が表示されるコマンドです

parameter

起動パラメータ(-p)の情報(デフォ値など)

vsl

vslのタグや出力フォーマットの説明

cli

varnishのcli(vcl.listなど)の説明を出力します

builtin

builtin.vclを出力します

HTTP/2がより使えるようになりました

5.0.0のHTTP/2は正直検証環境でも使うには辛いものだったのですが(POST投げると落ちるなど)

5.1.1では一部気をつけるポイントはあるものの検証環境で使えるぐらいには動きます。

また、HTTP/2関連は5.1.1リリース後も積極的にバグ修正が行われており、もし使いたい場合はこの記事で紹介したpkg-varnish-cacheを使って最新のコードで試すことをおすすめします。

なお、気をつけるポイントですが以下のとおりです。

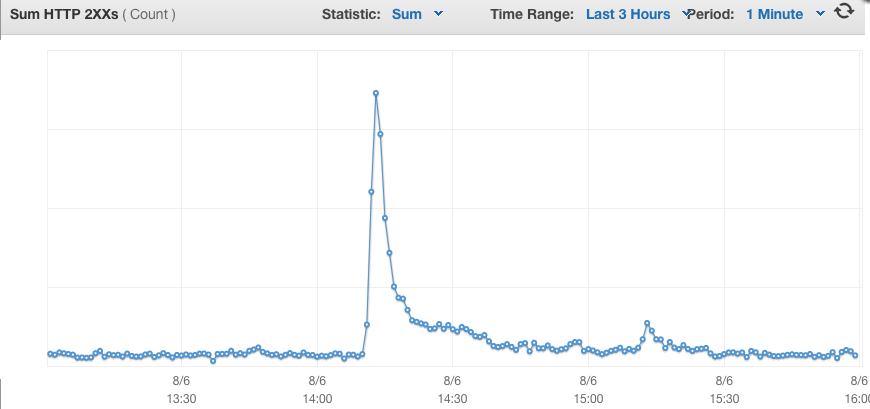

- 転送サイズ(varnishncsa %I %Oなど)などの統計がすべて0 #2238

- bodyがあるリクエストでcontent-lengthがある場合でもTransfer-Encoding: chunkedを付与する #2247

- クッキーの畳み込みを行わないのでVCLでクッキーの操作を行う場合に問題がある #2291 #2300

です。

統計については現時点ではどうしようもないのですが、ほかについては以下のVCLで一旦回避可能です。

もちろん修正された場合は不要となります。

sub vcl_recv{

if(req.http.cookie){

// temporary...

// https://github.com/varnishcache/varnish-cache/issues/2291

// https://github.com/varnishcache/varnish-cache/issues/2300

std.collect(req.http.cookie);

set req.http.cookie = regsuball(req.http.cookie,", ","; ");

}

if(req.proto ~ "HTTP/2"){

if(req.http.content-length){

// temporary...

// https://github.com/varnishcache/varnish-cache/issues/2247

unset req.http.content-length;

}

}

}

なお上記で行っているクッキーの畳み込みですが、もしESIを利用していない場合はHTTP/2に限定しても問題ありません。

他の注意点としてはPRIV_TASK/PRIV_TOPを利用しているvmodについては現時点では避けておいたほうが無難です。(HTTP/1では問題ありません)

またHTTP/2関連のパラメータとして以下が追加されています

- h2_rx_window_increment

- h2_rx_window_low_water

デフォルトは10MBで十分大きいので特に変更する必要ははなさそうですが、

大きなPOST/PUTを受ける場合は大きくしても良いかと思います。

即処理を終了するためのreturn(fail)が追加されました

これはどのvclアクションからも呼び出すことができます。

なおfailの後はvcl_synthがコールされますが、デフォルトでresp.statusには503がresp.reasonにはVCL failedが入っていますので、特に操作をしない場合はクライアントからは503が見えます。

なおvcl_synth内でfailを呼び出した場合は接続をアボート(即切り)します。

vcl_backend_responseでreturn(pass(DURATION))が追加されました

要はhit-for-passです。

TTLを同時に指定することができるので以前より指定しやすくなったので便利かと思います。

この辺(HFP等)わかりづらいとおもうので動きの解説記事をそのうちかきます・・

vsl queryでvxidの指定ができるようになりました

vxid(x-varnishレスポンスヘッダ)はリクエスト毎に発行されるので当然ながら事前にわかりません。

ヘルスチェックなどはvxid=0で実行されるのでそれの絞込ぐらいにしか使えないのかというとそうではなく

varnishncsaなどのlog系オプションの-dと組み合わせることで強力に使用できます。

varnishのログはメモリ上(VSM)に保存されるのですが、これはリングバッファのため古いログも多少残っています。

-dオプションは残っているログの先頭から出力するオプションのため、リクエストを行った後に取得したvxidを指定することでvarnishの挙動の確認を行うことが容易にできます。

fallback directorにstickeyオプションを追加しました

new fb = directors.fallback(sticky = true);

fallbackのdefaultの挙動では優先度の高いバックエンドがsickになった場合は当然fallbackします。

今回のstickeyオプションを指定するとこの優先度の高いバックエンドがhealthyになったときの挙動が変わります。

指定がない場合は優先度の高いバックエンドが選択されますが、指定がある場合はそのまま今繋いでるバックエンドを使用し続けます。

この動作は順繰り行われ、一番優先度の低いバックエンドがsickになった場合は再度先頭から評価されます。

起動時にvmodのバックアップを行うようにしました

これはVarnishの起動しているときにvmodの差し替えが行われて、その後の操作(reloadなど)でおかしくなることがあったので、使うvmodについてはバックアップを取るようになりました。

IPアドレス同士の比較ができるようになりました

vmod_stdにgetenvとlate_100_continueが追加されました

仕様変更

vcl_dirはvcl_pathに変更されます(起動パラメータ)

vmod_dirはvmod_pathに変更されます(起動パラメータ)

req.ttlは廃止予定です

beresp.storage_hintは廃止予定です

完全に同じものではないのですがberesp.storageで代替可能です。

レスポンスコードを1000以上でも指定できるようにしました

これはあくまでもVCL中で使うためのもので、実際にレスポンスされるときは1000以上の桁は削られます。

要はreturn(synth(1000))とかで指定しておいて、vcl_synthで処理するのに使う感じです。

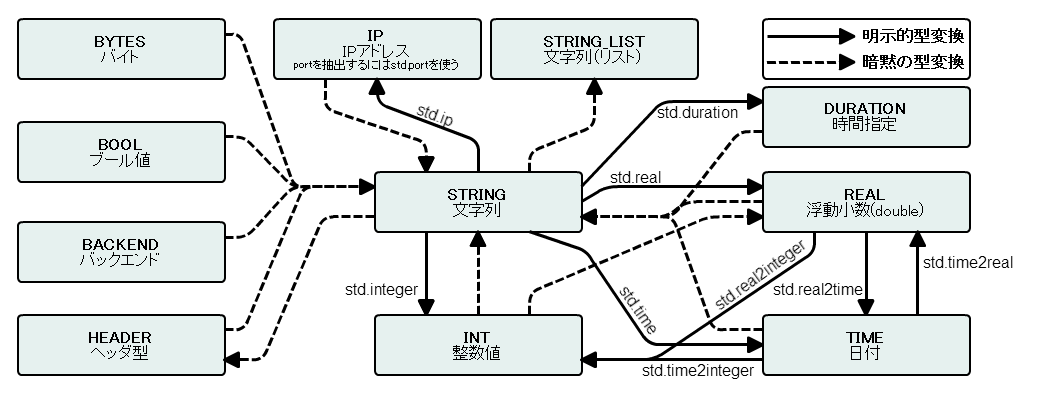

DURATION型をBOOL値として使用することができるようになりました

0以下はfalseでそれ以外はtrueです

TIME型にDURATIONを加算・減算できるようになりました

REAL型にINTを加算・減算できようになりました

パラメータの追加

ban_cutoffが追加されました(起動パラメータ)

req.storageが追加されました

これはrequst bodyを保存するのに使用されます。

未指定の場合はTransientが使用されます。

バグ修正

基本的には4.1.4/4.1.5で修正されたものが大きいものだったので割愛します。